티스토리 뷰

[ 밑줄/연결 ]

(변수와 상수)

인공지능에서 사용하는 모델 중 하나인 신경망에서는 '가중치'라는 개념이 있는데, 컴퓨터가 이러한 가중치를 스스로 학습하며 결정하게 됩니다.

컴퓨터가 가중치를 학습할 때는 가중치가 '변수'의 역할을 하는데, 학습이 끝나고 해당 가중치를 학습 모델에 활용할 때는 '상수'의 역할을 한다.

(삼각함수)

인공지능 분야에서는 음성 인식을 할 때, 음의 파형을 분석하기 위해 '푸리에 변환'을 사용합니다.

푸리에 변환은 복잡한 파형을 가진 함수를 삼각함수의 덧셈으로 표현하는 변환 방법입니다.

(유클리드의 거리)

인공지능 분야에서는 과거의 데이터를 분석하여 최적의 모델을 만드는 학습 단계와, 그렇게 만들어진 모델을 사용해서 새로운 데이터에 대한 카테고리나 수치를 예측하는 추론 단계가 있습니다.

유클리드 거리는 인공지능 분야에서 사용되는데, 그중 하나가 k-NN 이라는 분류 방법입니다....

학습 단계에서 학습된 데이터를 벡터 공간상에 위치시킨 후, 추론 단계에서 새로운 데이터를 같은 공간에 배치합니다.

새 데이터가 어떤 카테고리에 속하는지 알기 위해서는 가까이에 있는 k개의 정답 데이터를 보고 추론하게 되는데, 이때 사용하는 것이 바로 유클리드 거리입니다.

(수열)

(초등함수와 합성함수의 미분, 그리고 곱의 법칙)

신경망에서는 학습한 결과로 도출된 답이 정답 데이터에 가까워질 수 있도록 가중치(w)를 조정하는 과정을 반복합니다.

이때, 실제 정답과 학습 결과 사이의 오차 값을 가중치로 편미분한 다음, 그 값을 가중치의 조정량으로 사용합니다.

이렇게 편미분을 하는 과정에서 연쇄법칙이 사용되는데, 이런 일련의 기법을 오류역전파법이라고 합니다.

(덧셈과 뺄셈, 그리고 스칼라배)

스칼라배는 벡터에 대비되는 개념으로 크기만 있고 방향이 없는 상수나 변수 같은 2차원의 값을 의미합니다.

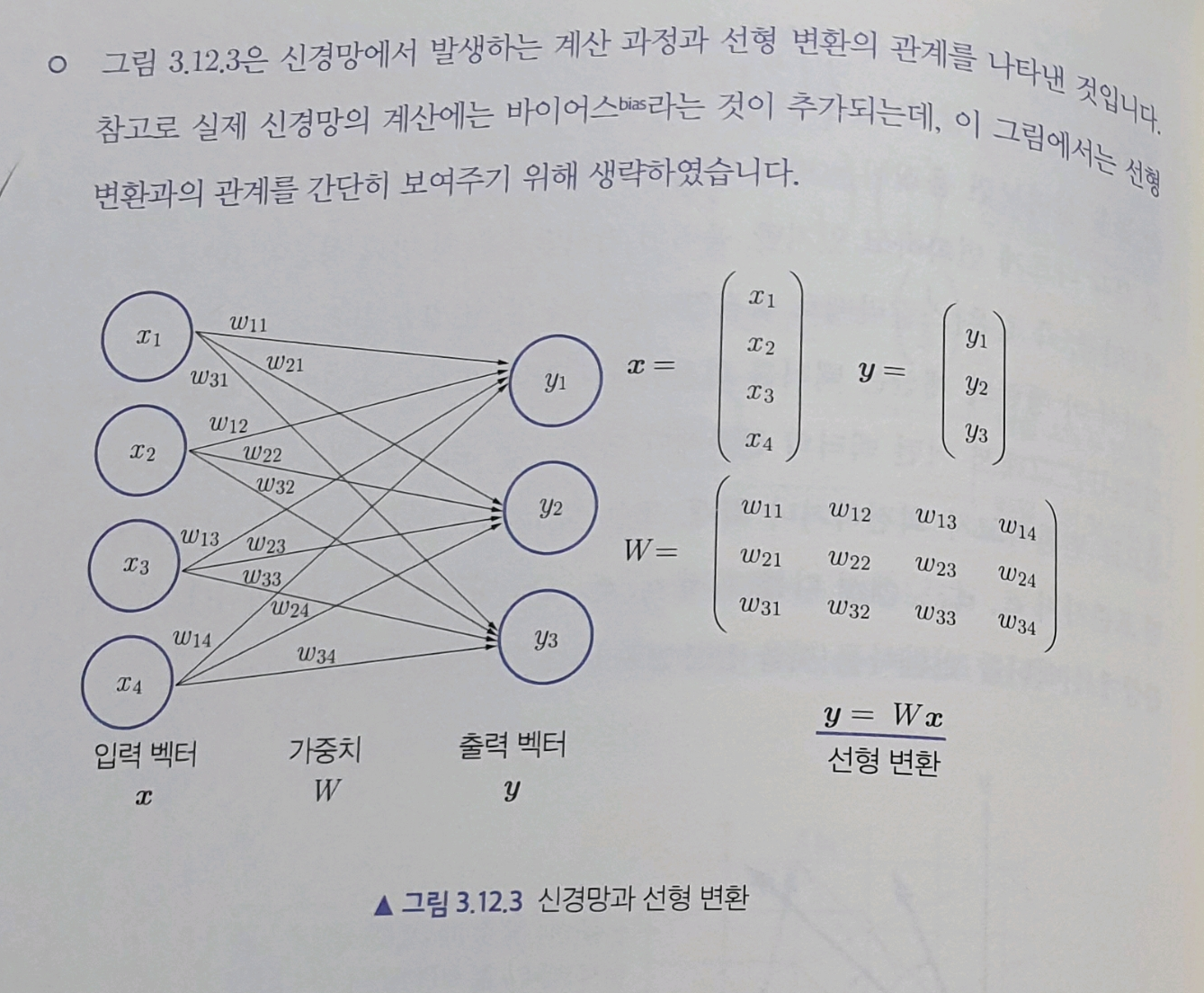

(선형 변환)

수학적으로 벡터에 행렬을 곱해 또 다른 벡터를 만드는 함수를 말합니다.

다르게 표현하자면 하나의 벡터 공간에서 또 다른 벡터 공간으로, 벡터의 특징을 유지한 채 변환하는 방법이라고도 할 수 있습니다.

신경망에서....파라미터와 가중치를 곱하는 과정을 일종의 선형변환으로 볼 수 있습니다.

[ 자평 ]

서가에 소장하고 있는 딥러닝 관련 책 중 일반독자를 위한 가장 범용적으로 넓게 잘 써진 초기 책은 2015년 번역본인 < 마쓰오 유타카> 교수의 책이다. 신경망에 대해 대중적이면서 어느 정도 깊이있게 다룬 초기 책은 2017년에 번역된 < 타리크 라시드 (Tariq Rashid)>의 책이다. 정말 잘 썼고, 정말 많이 배웠고, 정말 좋았던 기억이 있어 소중히 소장하고 있다.

이후 다 읽지는 못하고 있지만 이 분야 가장 강력한 내공의 책은 2017년 부터 2025년까지 나오고 있는 <사이토 고키>의 '밑바닥 부터 시작하는' 시리즈라고 본다.

기술자가 아닌 기획자들은 1권만 다 읽고 이해하고, 3권은 프레임워크의 개념과 구현 흐름 정도만 이해하도 충분하지 않을까 싶다. 6판은 '대구모 언어 모델'을 다룬다고 하니, 내가 아직 밥벌이를 한다면 또 사서 봐야 했을 것 같다.

2018년에 나온 책이고, 정리 차원에서 한 번 더 본 후 살처분한다.

요즈음 이런 컨셉의 더 좋은 책이 나오기 때문이다. 아래가 근래 훑어 본 책 중 괜찮아 보이는 책인데, 역시 개발자가 아니고 이 분야 밥벌이를 할 확률이 적어서 사서 보지는 않았다.

'지능 > 인공지능' 카테고리의 다른 글

| AI시대 생존 전략 by 세가 챙 (1) | 2025.03.01 |

|---|---|

| AI경제학 by 어제이 애그러월 (Ajay Agrawal) 외 (1) | 2025.02.18 |

| 수학 지능 by 주나이드 무빈 (1) | 2024.02.12 |

| 기계의 반칙 by 넬로 크리스티아니니 (0) | 2023.12.31 |

| 괄호로 만든 세계 by 마이클 울드리지 (0) | 2023.12.25 |

- Total

- Today

- Yesterday

- 직감하는 양자역학

- 게티어 문제

- 개념

- 복잡계의 새로운 접근

- 데브옵스 도입 전략

- 참을 수 없는 존재의 가벼움

- 파괴적 혁신

- 상대성이론

- 고도를 기다리며

- 부정성 편향

- 최진석

- 안나 카레니나

- 경영혁신

- 스케일의 법칙

- 도파민의 배신

- 지식의 정의

- 양자역학

- 사회물리학

- 혁신

- 샤룩 칸

- 돈

- 지식론

- Ai

- 사고의 본질

- 불교

- 게티어

- 인식론

- 머신러닝 디자인 패턴

- 이노베이션

- 인공지능

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |